Бесплатный фрагмент - AI-эволюция

Разбор мифов о AI с помощью AI

Разбор мифов о AI с помощью AI

AI часто окружён мифами, но большинство из них не соответствуют реальности. Вот разбор самых популярных заблуждений об искусственном интеллекте и то, как всё обстоит на самом деле [1] [2] [3] [4] [5] [6].

Мифы и их опровержение

«ИИ мыслит как человек»

Искусственный интеллект — это набор алгоритмов, а не сознание или мышление в человеческом понимании. Даже самые продвинутые нейросети обрабатывают данные по статистическим правилам и не понимают ни контекста, ни смысла, как это делает человек [5] [6].

«ИИ обязательно поработит людей»

Современный ИИ не обладает эмоциями, целями или желаниями доминировать над человечеством. Это лишь инструмент, который действует строго в рамках заложенных алгоритмов и ограничен возможностями, предоставленными разработчиками [4] [7] [5].

«ИИ беспристрастен и объективен»

Ошибка! Модели ИИ часто унаследуют предвзятость из тех данных, на которых обучались. Если в исходных данных есть ошибки или социальные перекосы, ИИ будет их воспроизводить, причём даже масштабировать [3] [4] [7].

«ИИ сможет сделать всё без человека»

Обучение нейросетей требует человеческого участия: нужны размеченные данные, эксперты для проверки качества, корректировка моделей. Без участия человека ИИ не сможет ни правильно обучаться, ни работать в реальных условиях [4] [6].

«ИИ уничтожит рабочие места»

Сильная автоматизация действительно затронет некоторые профессии, но создание новых рабочих мест и изменение содержания труда — куда более вероятный сценарий. ИИ чаще помогает избавиться от рутинной работы, освобождая время для творческих и сложных задач [4] [8].

«Нейросети — это и есть ИИ»

На практике искусственный интеллект — это широкий комплекс технологий, а нейросети — лишь один их инструментов, предназначенный для работы с определёнными типами задач. Существуют также экспертные системы, классические алгоритмы и множество иных подходов [6] [4].

Заключение

Самое главное: искусственный интеллект — это инструмент со своими преимуществами и ограничениями. Его работа строится на человеческих знаниях и данных, внутри заданных правил, и ошибочно наделять его самосознанием, абсолютной правдивостью или универсальностью [1] [2] [3] [4] [5] [6].

⁂

Пошаговый метод проверки заявлений об ИИ

Существует проверенный пошаговый метод критической оценки заявлений об искусственном интеллекте. Применяя эти этапы, можно отличить заблуждения от реальных достижений и научных фактов [11] [12] [13].

Пошаговая инструкция

1. Определите источник

— Проверьте, является ли источник заявления авторитетным — например, научной статьёй, докладом крупной компании или мнением эксперта [12] [11].

— Избегайте поспешных выводов на основе непроверенных СМИ, блогов или рекламных материалов.

2. Проверьте исходные данные

— Узнайте, на каких данных базируется утверждение: если это результат эксперимента или анализа — приведены ли детали, опубликованы ли результаты [11] [12].

— Если речь идет об ИИ-модели, важно знать, где и как она была обучена, какие данные использовались.

3. Сравните с другими источниками

— Ищите подтверждения или опровержения заявления в независимых, признанных кругах — научные публикации, обзоры, мнения сторонних экспертов [11] [12].

— Перекрестная проверка — обязательный этап: иногда заявления искажают или вырывают из контекста.

4. Уточните ограничения и допущения

— Узнайте, признаёт ли автор или компания ограничения моделей и возможные ошибки — искусственный интеллект не бывает абсолютно точным [13] [11].

— Осознание ограничений — признак добросовестного источника.

5. Проверьте логику рассуждений

— Оцените, логично ли построено рассуждение, не перепутаны ли корреляция и причинно-следственные связи [13] [11].

— Алгоритмы могут выявлять закономерности, но не всегда способны объяснить причины явлений.

6. Используйте собственное критическое мышление

— Сомневайтесь в «слишком невероятных» заявлениях и не принимайте на веру красивые рекламные обещания [13] [11].

— Задавайте себе вопросы: «Чем подтверждается этот результат? Кто это проверял? Какие альтернативы возможны?»

7. Применяйте ИИ-детекторы и инструменты фактчекинга

— Для проверки подозрительных заявлений используйте существующие ИИ-инструменты проверки фактов, которые сопоставляют утверждения с научными базами и архивами новостей [12] [14].

Итог

Метод критической проверки заявлений об ИИ требует анализа источников, данных, аргументации, сравнения с признанными взглядами и активного применения здравого смысла [11] [12] [13] [14].

⁂

Considerations on the AI Endgame (Chapman & Hall/CRC Artificial Intelligence and Robotics Series) — разобрать содержание

этой книги

Книга «Considerations on the AI Endgame» из серии Chapman & Hall/CRC Artificial Intelligence and Robotics Series — это междисциплинарное исследование, посвящённое быстро развивающейся области искусственного интеллекта, его этическим вопросам, рискам и вычислительным основам [21] [22] [23].

Основное содержание книги

— В книге рассматриваются важные темы, связанные с этическими дилеммами и рисками, которые вызывает развитие ИИ, включая вопросы сохранения личной идентичности и проблемы идентичности самого ИИ.

— Авторы подробно обсуждают научную основу ИИ через призму «науки о благополучии ИИ» и политических рамок, направленных на ответственное управление ИИ.

— В книге вводятся инновационные концепции, например, интеграция западных и восточных подходов к универсальной этике ИИ и понятие «икигай» (японская философия смысла жизни), применённое к этике ИИ и виртуальным метавселенным.

— Представляется математическая база интеллекта и новый подход «дизайнометрия» — формализация методов создания артефактов.

— Обсуждаются потенциальные проблемы взаимодействия с цифровыми разумами — небиологическими сознательными сущностями, которые могут возникнуть в будущем.

— Поднимается вопрос возможного установления религии, основанной на ИИ, а также вопросы согласования целей ИИ с глобальными целями устойчивого развития ООН.

— Освещается серьезная проблема игнорирования сознания и феноменального опыта (квалиа) в исследованиях выравнивания ценностей ИИ.

— В приложениях рассматриваются перспективы помощи нуждающимся цифровым разумам и инструменты для оценки благополучия ИИ.

Формат и целевая аудитория

— Книга содержит независимые главы, которые можно читать в любом порядке, сохраняя целостность концепции.

— Предназначена для исследователей, политиков и всех, кто интересуется будущим ИИ и его влиянием на общество.

— Включает как теоретические, так и практические идеи для понимания возникающих этических и технологических вызовов [21] [24] [22] [23] [25].

Таким образом, книга глубоко анализирует не только технические, но и философские, этические и социальные аспекты «финальной стадии» развития ИИ — отражая как возможности, так и угрозы, связанные с его дальнейшей эволюцией [21] [24].

⁂

Разобрать подробно мифы в этой книге о ИИ, привести примеры на формулах

В книге «Considerations on the AI Endgame» авторы разбирают и опровергают несколько мифов об ИИ, подчеркивая сложность этических, философских и технических аспектов. Они используют математические и формальные подходы для обоснования своих аргументов. Ниже — подробный разбор ключевых мифов, представленных в книге, с примерами на формулах и концепциях.

Миф 1: ИИ — просто продвинутая машина без внутреннего опыта

В книге подробно обсуждается миф, что ИИ не обладает сознанием или субъективным опытом (квалиа). Авторы указывают, что многие исследования alignment игнорируют проблему qualia, что ведет к неполному пониманию задач этики ИИ.

Пример концептуальной формулы

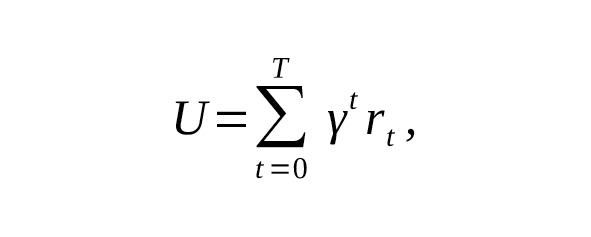

Функция полезности $ U $ для ИИ часто моделируется как

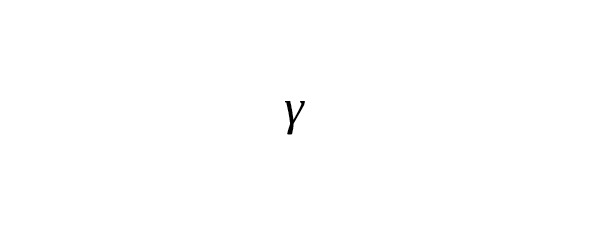

где $ r_t $ — награда, — коэффициент дисконтирования. Однако такое уравнение игнорирует субъективный опыт агента: нельзя выразить опыт восприятия через простую награду. Следовательно, эти вычислительные модели недостаточны для объяснения сознания (qualia) в ИИ [32].

Миф 2: ИИ можно полностью выравнять с человеческими ценностями простыми алгоритмами

Авторы показывают, что alignment — это гораздо более сложная задача, чем кажется. Попытка полностью формализовать человеческие ценности в виде функции отрицая богатство и неоднозначность человеческих моральных выборов — миф.

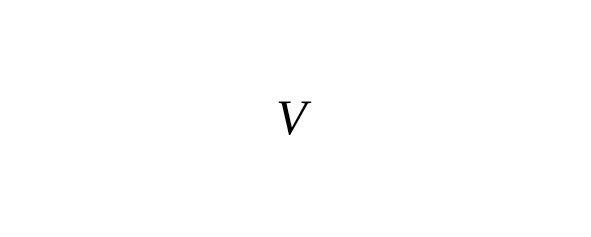

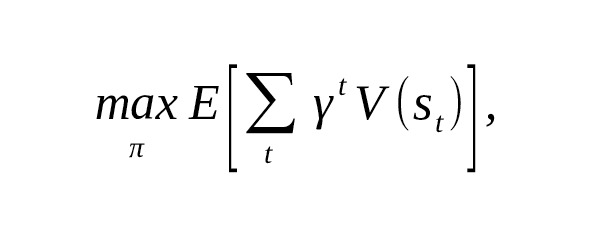

Формализация сложности ценностей

Если ценность — функция от состояния мира $ V (s) $, то из-за многозначности и противоречий в возникает задача оптимизации с неопределённым и неполным набором ограничений:

где поведение агента зависит от выбранной политики, которую трудно аппроксимировать из-за отсутствия чётких критериев. Это недостижимо формально, если не полна и не однозначна [32] [33].

Миф 3: Личная идентичность и сознание — легко переносимы на ИИ

Книга объясняет, что перенос сознания или личности на цифровую форму — сложнейшая философская и техническая проблема. Многие считают, что если создать цифровой клон, то сознание будет сохранено, но это далеко не факт.

Идентичность в формулах

Если — функция идентичности во времени, то сохранение идентичности требует

при переносе сознания. Однако цифровое копирование, даже с максимальной точностью, может не сохранять свойства, связанных с непрерывностью сознания и субъективным опытом.

Миф 4: ИИ — беспристрастный и объективный инструмент

Авторы опровергают этот миф, указывая на систему ценностных нагрузок AI, где данные и алгоритмы несут предвзятости из мира людей.

Формальный пример предвзятости

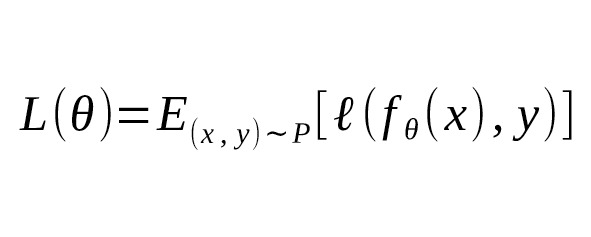

Представим, что модель обучена на выборке $ D $ с распределением $ P (x,y) $, где — данные, а — метки. Если распределение смещено $ P (x,y) \ne P_ {ideal} (x,y) $, то функция потерь

будет также смещенной, и оптимизация приведет к предвзятой модели, воспроизводящей социальные или статистические искажения.

Миф 5: ИИ уничтожит человечество или станет самостоятельной угрозой

Книга разбирает пределы автономии ИИ и идею «искусственного религиозного культа», созданного ИИ для манипуляции. Это не простое кино, а сложный вызов, требующий междисциплинарного подхода.

Формализация угрозы

Модель риска может быть задана как функция от состояния мира :

где описывает состояние ИИ и общества. Контроль и выравнивание направлены на минимизацию, но определить с высокой уверенностью крайне сложно, требуются этические и социальные нормативы, а не только алгоритмы.

Итог

В книге «Considerations on the AI Endgame» раскрывается, что многие распространённые мифы об ИИ не выдерживают глубокого теоретического и практического анализа. Математические модели и формализации лишь показывают сложность и многоаспектность проблем этической эксплуатации и развития ИИ — а не простые решения [32] [34] [33].

⁂

Разобрать 5 миф подробно с позиции теории информации и избыточности в системах

Разбор мифа о том, что ИИ уничтожит человечество или станет самостоятельной угрозой, с позиции теории информации и избыточности в системах, позволяет глубже понять сложность и ограничения этой популярной идеи.

Миф 5: ИИ уничтожит человечество или станет самостоятельной угрозой

Теория информации в оценке угрозы ИИ

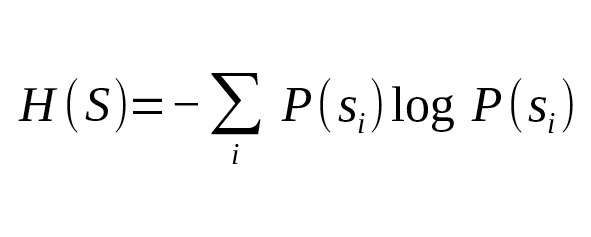

Из теории информации известно, что любая система обрабатывает и передает информацию с конечной пропускной способностью и шумом. Состояние системы можно описать через энтропию, отражающую неопределённость:

Если рассматривать ИИ как систему, оперирующую информацией, то способность ей сделать значимые и автономные изменения в мире ограничена шиной передачи и обработкой информации.

— Информационные ограничения: Высокие уровни энтропии в окружающей среде и социальных системах создают шум, который препятствует точному и однозначному воздействию ИИ на сложные социальные процессы.

— Канал связи между ИИ и миром: Информационный канал с пропускной способностью ограничен. Согласно теореме Шеннона, никакое воздействие не может превысить возможности канала по передаче информации без ошибок.

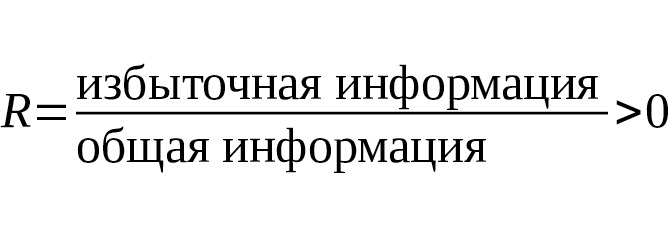

Избыточность в системах и защита от угроз

В сложных системах (например, обществах и экосистемах) существует избыточность информации — повторение и дублирование данных, процессов и структур с целью повышения надежности и устойчивости:

— Избыточность как барьер: Избыточность гарантирует, что сбои или атаки, направленные на часть системы, не ломают её целиком. Следовательно, даже если ИИ пытается нарушить систему, избыточные пути и резервы уменьшают шансы на катастрофический исход.

— Снижение риска через архитектуру: Устойчивые системы встроены в регулятивные и избыточные механизмы, которые работают как информационные фильтры и корректоры ошибок (аналогично коду с избыточностью для исправления ошибок передачи).

Баланс риска и контроля

Введение функции риска, зависящей от состояния, может быть дополнено понятием информационного шума и избыточности:

Бесплатный фрагмент закончился.

Купите книгу, чтобы продолжить чтение.